コンテンツ投稿&コンテンツマイニングイールドで収益を得よう

placeholder

MrMamunurRashid

🔹 基本ルール

• 取引ごとのリスク:総資産の1〜2%を超えないこと

• 同時取引:最大1〜2件

• 損失後:直ちに停止 (リベンジ取引禁止)

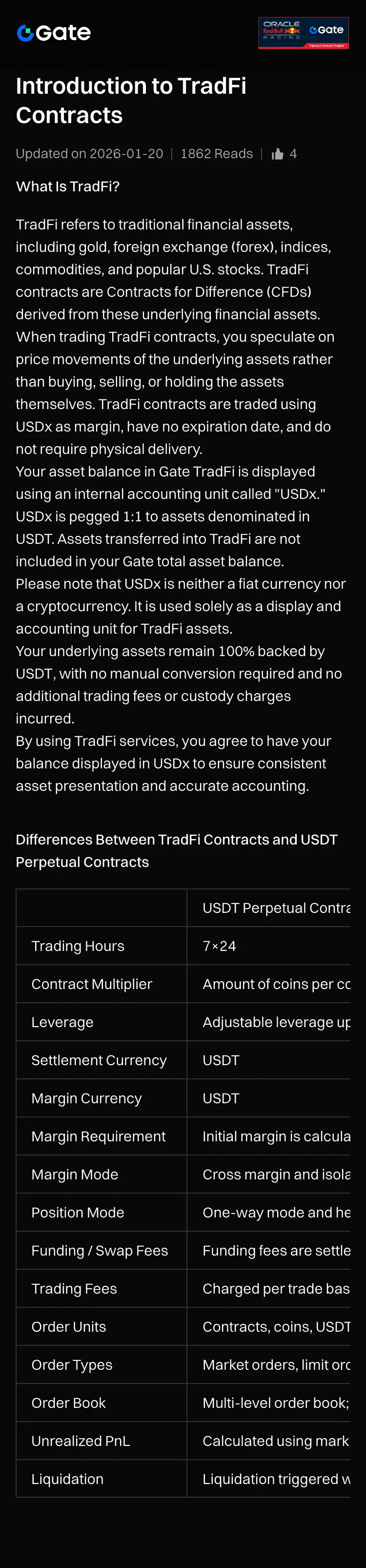

🔹 セットアップ (Gate TradFi)

• 証拠金モード:分離型

• 注文タイプ:リミット (マーケット注文はスリッページが多くなる)

• ストップロス:必ず使用

• テイクプロフィット:リスク:リワード = 1:1.5 または 1:2

🔹 セットアップ (Pocket Option)

• 取引金額:残高の5%を超えないこと

• マーチンゲール ❌ (絶対に使用しない)

• 過剰取引 ❌

⸻

✅ 2) レバレッジは何が最適?

🔰 初心者向け (安全範囲)

市場

レバレッジ

金

3x – 5x

外国為替

3x – 5x

指数

2x – 3x

暗号資産

3x

✅ 3) 最適な取引時間

⏰ 最適取引時間 (バングラデシュ時間)

🔹 外国為替 / 金

• 🟢 6:00 PM – 10:00 PM

(ロンドン + ニューヨークの重複時間)

🔹 米国株 / 指数

• 🟢 8:30 PM – 11:00 PM

🔹 Pocket Option

• 🟢 市場ボリュームが高いとき

• ❌ 1:00 AM – 5:00 AM (フェイク動きが多い)

⸻

✅ 4) Pocket Option vs Gate T

原文表示• 取引ごとのリスク:総資産の1〜2%を超えないこと

• 同時取引:最大1〜2件

• 損失後:直ちに停止 (リベンジ取引禁止)

🔹 セットアップ (Gate TradFi)

• 証拠金モード:分離型

• 注文タイプ:リミット (マーケット注文はスリッページが多くなる)

• ストップロス:必ず使用

• テイクプロフィット:リスク:リワード = 1:1.5 または 1:2

🔹 セットアップ (Pocket Option)

• 取引金額:残高の5%を超えないこと

• マーチンゲール ❌ (絶対に使用しない)

• 過剰取引 ❌

⸻

✅ 2) レバレッジは何が最適?

🔰 初心者向け (安全範囲)

市場

レバレッジ

金

3x – 5x

外国為替

3x – 5x

指数

2x – 3x

暗号資産

3x

✅ 3) 最適な取引時間

⏰ 最適取引時間 (バングラデシュ時間)

🔹 外国為替 / 金

• 🟢 6:00 PM – 10:00 PM

(ロンドン + ニューヨークの重複時間)

🔹 米国株 / 指数

• 🟢 8:30 PM – 11:00 PM

🔹 Pocket Option

• 🟢 市場ボリュームが高いとき

• ❌ 1:00 AM – 5:00 AM (フェイク動きが多い)

⸻

✅ 4) Pocket Option vs Gate T

- 報酬

- いいね

- コメント

- リポスト

- 共有

前日に仕掛けた伏兵ポイントが、今日は予定通り爆発!正しい人に正しいことをやるだけで、肉を食べるのはこんなに簡単だ。ビットコインは1260ポイント、愛人は70ポイント、AXSも0.37ポイント。

#GateLaunchpadIMU #欧美关税风波冲击市场

原文表示#GateLaunchpadIMU #欧美关税风波冲击市场

- 報酬

- 1

- 1

- リポスト

- 共有

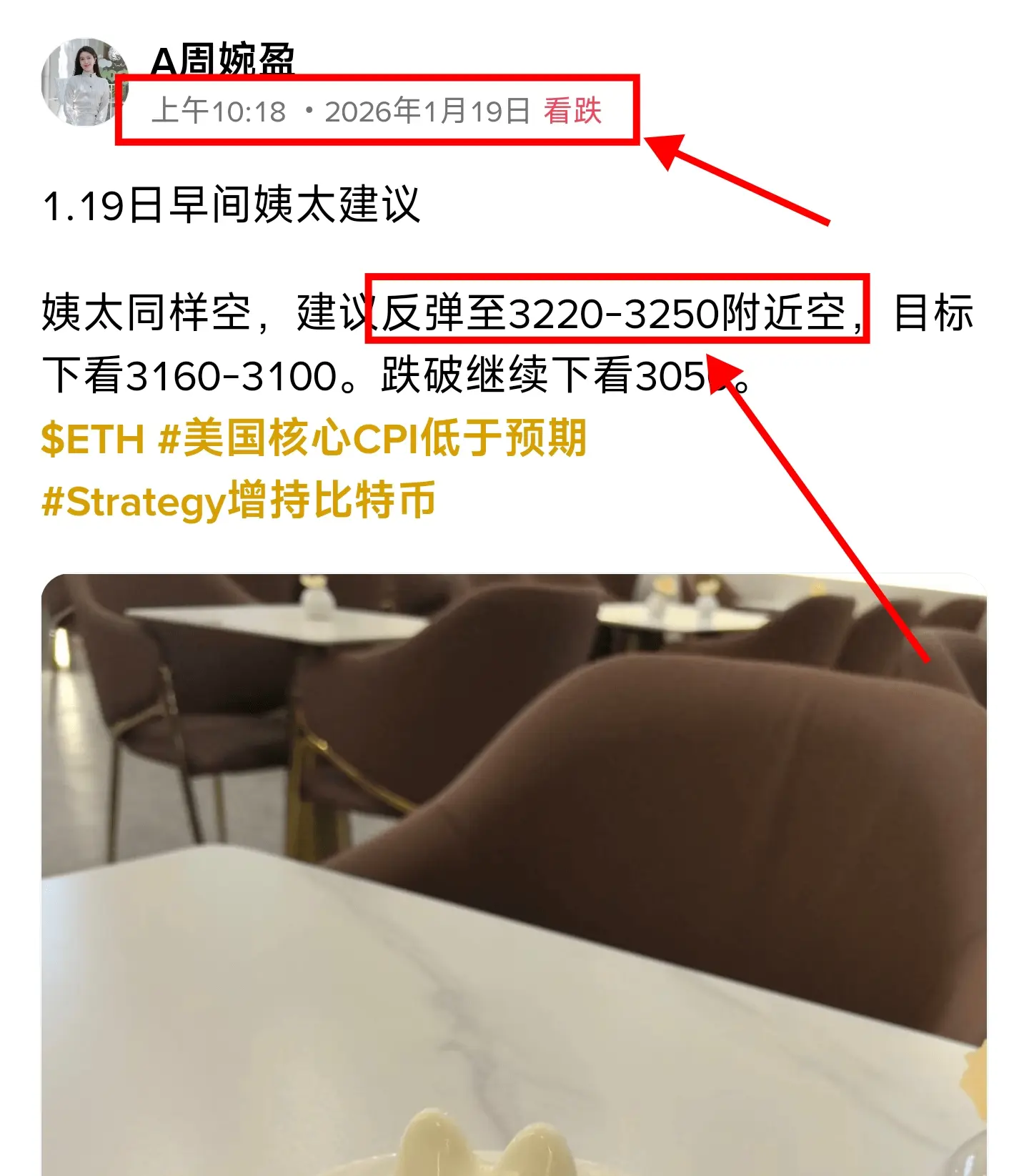

AZhouWanying :

:

しっかり座って、しっかりつかまってください。まもなく離陸します 🛫#欧美关税风波冲击市场 先明确核心結論:GAT(グラフ注意力ネットワーク)はGNNの重要な分野であり、核心は注意力メカニズムを利用して隣接ノードの重みを動的に割り当てることで、GCNなどの固定重みの制約を解決し、自適応性、並列処理、解釈性を兼ね備え、異質/動的グラフやノード分類などのタスクに適している。ただし、計算コストや過学習のリスクも存在する。以下、原理、長所と短所、応用例と実践ポイントについて展開する。

一、核心原理

- ノードは「どの隣接ノードにより注目すべきか」を学習し、注意重みを用いて隣接情報を加重集約し、より正確なノード表現を得る。

- 計算フロー:

1. ノード特徴を重み行列で投影し、新空間に線形変換。

2. 自注意力を用いて隣接ノード間の関連スコアを計算し、softmaxで正規化。

3. 注意重みに基づき隣接ノードの特徴を集約し、同時にノード自身の情報も保持。

4. マルチヘッド強化技術を用いて、中間層で複数のヘッド出力を結合し次元拡張、出力層で平均を取り安定性を向上。

二、核心の長所

- 自適応加重:グラフ構造に依存せず、データ駆動で重みを学習し、複雑な関係に適応。

- 高効率並列:隣接重みは独立して計算可能で、全体の隣接行列に依存しないため、大規模・動的グラフに適合。

- 解釈性:注意重みの可視化により、重要な接続や意思決定の根拠を分析しやすい

原文表示一、核心原理

- ノードは「どの隣接ノードにより注目すべきか」を学習し、注意重みを用いて隣接情報を加重集約し、より正確なノード表現を得る。

- 計算フロー:

1. ノード特徴を重み行列で投影し、新空間に線形変換。

2. 自注意力を用いて隣接ノード間の関連スコアを計算し、softmaxで正規化。

3. 注意重みに基づき隣接ノードの特徴を集約し、同時にノード自身の情報も保持。

4. マルチヘッド強化技術を用いて、中間層で複数のヘッド出力を結合し次元拡張、出力層で平均を取り安定性を向上。

二、核心の長所

- 自適応加重:グラフ構造に依存せず、データ駆動で重みを学習し、複雑な関係に適応。

- 高効率並列:隣接重みは独立して計算可能で、全体の隣接行列に依存しないため、大規模・動的グラフに適合。

- 解釈性:注意重みの可視化により、重要な接続や意思決定の根拠を分析しやすい

- 報酬

- いいね

- コメント

- リポスト

- 共有

m

币世界

作成者@币安心

上場の進行状況

0.00%

時価総額:

$3.46K

自分のトークンを作成

Gate 年度帳單が公開!一緒に私の年間パフォーマンスを見てみましょう

リンクをクリックしてあなた専用の #2025Gate年度账单 を確認し、20 USDTのポジション体験券を受け取りましょう https://www.gate.com/zh/competition/your-year-in-review-2025?ref=VQJMVG8NUQ&ref_type=126&shareUid=U1dCUl5WBAUO0O0O

原文表示リンクをクリックしてあなた専用の #2025Gate年度账单 を確認し、20 USDTのポジション体験券を受け取りましょう https://www.gate.com/zh/competition/your-year-in-review-2025?ref=VQJMVG8NUQ&ref_type=126&shareUid=U1dCUl5WBAUO0O0O

- 報酬

- いいね

- コメント

- リポスト

- 共有

1. 庆庆马币,吉庆添财

2. 庆庆在手,马年暴富

3. 庆启新岁,马币纳福 没有庄家砸盘全是散户

2. 庆庆在手,马年暴富

3. 庆启新岁,马币纳福 没有庄家砸盘全是散户

[ユーザーは自分の取引データを共有しました。アプリに移動して詳細を表示します]

時価総額:$4.64K保有者数:44

5.76%

- 報酬

- いいね

- コメント

- リポスト

- 共有

試してみようと思ってChatGPTに尋ねてみました

私がどう扱うか、2025年には毎日一緒に働いていたので

プロンプトを入力しました

「あなたをどう扱うかのイメージを作成してください」

そして、これがChatGPTが作ったものです

ちょっと質問です:

@grok あなたは同じように扱われたいですか?

原文表示私がどう扱うか、2025年には毎日一緒に働いていたので

プロンプトを入力しました

「あなたをどう扱うかのイメージを作成してください」

そして、これがChatGPTが作ったものです

ちょっと質問です:

@grok あなたは同じように扱われたいですか?

- 報酬

- いいね

- コメント

- リポスト

- 共有

📌 無料エアドロップに参加しよう!Perleエアドロップ

訪問先:

- Googleで登録

- Phantomウォレットを連携

タスクを完了

- 完了

エアドロップ通知!

#airdrop alert

原文表示訪問先:

- Googleで登録

- Phantomウォレットを連携

タスクを完了

- 完了

エアドロップ通知!

#airdrop alert

- 報酬

- 1

- 1

- リポスト

- 共有

Ryakpanda :

:

2026年ラッシュ 👊昨日、ニューヨーク証券取引所(NYSE)が公式に発表したことが話題になっています。ウォール街が自らブロックチェーンに上場し始めたのです。

これは2026年の暗号通貨界で最も重要なシグナルの一つになる可能性があります。

NYSEおよびその親会社ICEは、トークン化された証券取引プラットフォームの開発を正式に発表し、現在SECに承認申請中です。

このプラットフォームは24時間365日取引と秒単位の決済を実現し、深夜にNVIDIAを買いたいときや週末に底値を狙いたいときも可能です。従来の米国株はT+1の待ち時間が必要ですが、オンチェーンの米国株は秒で決済されます。

断片化された取引とステーブルコインによる支払いにより、NVIDIAの株を丸ごと買えなくても、今なら10ドル分だけ購入可能です。NYSEもステーブルコインの受け入れを始めており、暗号通貨と伝統的な金融の壁がウォール街自身によって崩されつつあります。

私たち個人投資家にとっての影響は何でしょうか?

物語は完全に変わりました。以前は「ブロックチェーンは詐欺だ」と言われていました。

しかし今やNYSEが自ら上場取引プラットフォームを構築し、ステーブルコインによる支払いも受け入れるのです。これは私たちが彼らに受け入れを求めているのではなく、彼らが積極的に私たちの技術を使おうとしているのです。

ステーブルコインの地位は大きく変わりつつあり

原文表示これは2026年の暗号通貨界で最も重要なシグナルの一つになる可能性があります。

NYSEおよびその親会社ICEは、トークン化された証券取引プラットフォームの開発を正式に発表し、現在SECに承認申請中です。

このプラットフォームは24時間365日取引と秒単位の決済を実現し、深夜にNVIDIAを買いたいときや週末に底値を狙いたいときも可能です。従来の米国株はT+1の待ち時間が必要ですが、オンチェーンの米国株は秒で決済されます。

断片化された取引とステーブルコインによる支払いにより、NVIDIAの株を丸ごと買えなくても、今なら10ドル分だけ購入可能です。NYSEもステーブルコインの受け入れを始めており、暗号通貨と伝統的な金融の壁がウォール街自身によって崩されつつあります。

私たち個人投資家にとっての影響は何でしょうか?

物語は完全に変わりました。以前は「ブロックチェーンは詐欺だ」と言われていました。

しかし今やNYSEが自ら上場取引プラットフォームを構築し、ステーブルコインによる支払いも受け入れるのです。これは私たちが彼らに受け入れを求めているのではなく、彼らが積極的に私たちの技術を使おうとしているのです。

ステーブルコインの地位は大きく変わりつつあり

- 報酬

- いいね

- コメント

- リポスト

- 共有

- 報酬

- 4

- 6

- リポスト

- 共有

LittleQueen :

:

明けましておめでとうございます! 🤑もっと見る

- 報酬

- 1

- コメント

- リポスト

- 共有

最新:⚡ Paradexは、データベースのエラーにより一時的にBitcoinを$0 にクラッシュさせた後、ブロックチェーンをロールバックします。これにより、エンジニアが問題を特定して取引を停止するまで、大量の清算が発生しました。

BTC-2.23%

- 報酬

- いいね

- コメント

- リポスト

- 共有

🔥 Watch-to-Earn Giveaway — 残り1日!

🎁 賞品はまだまだ獲得可能 — Heat Pointsを無駄にしないでください

GT|Gate × Red Bull Jackek & Cap|$50 ポジションバウチャー

何か気になるものはありますか? 👀

⏱ 最終スプリント — すべての動きを無駄にしないで

毎日のチェックイン → ライブ視聴 → コメント → ストリーム予約 → コピー取引

すべてのアクションがあなたの勝つチャンスを高めます。

👉 ライブ視聴:https://www.gate.com/live

🎰 今すぐ抽選:https://www.gate.com/activities/watch-to-earn?now_period=14

🎁 賞品はまだまだ獲得可能 — Heat Pointsを無駄にしないでください

GT|Gate × Red Bull Jackek & Cap|$50 ポジションバウチャー

何か気になるものはありますか? 👀

⏱ 最終スプリント — すべての動きを無駄にしないで

毎日のチェックイン → ライブ視聴 → コメント → ストリーム予約 → コピー取引

すべてのアクションがあなたの勝つチャンスを高めます。

👉 ライブ視聴:https://www.gate.com/live

🎰 今すぐ抽選:https://www.gate.com/activities/watch-to-earn?now_period=14

GT-1.48%

- 報酬

- 2

- 1

- リポスト

- 共有

HighAmbition :

:

2026年ゴゴゴ 👊1211

god

作成者@JigmeNgeduup

申込状況

0.00%

時価総額:

$0

自分のトークンを作成

$GAT 先明确核心结论:GAT(グラフ注意力ネットワーク)はGNNの重要な分野であり、核心は注意力メカニズムを用いて隣接ノードの重みを動的に割り当てることにより、GCNなどの固定重みの制約を解決し、適応性、並列処理、解釈性を兼ね備え、異質/動的グラフやノード分類などのタスクに適している。ただし、計算コストと過学習のリスクも存在する。以下、原理、長所と短所、応用例と実践のポイントについて展開する。

一、核心原理(一言+フロー)

- 一言:ノードは「どの隣接ノードにより注意を向けるか」を学習し、注意重みで隣接情報を加重集約して、より正確なノード表現を得る。

- 計算フロー:

1. 線形変換:ノード特徴を重み行列で投影し新空間へ

2. 注意計算:自己注意を用いて隣接ノード間の関連スコアを算出し、softmaxで正規化

3. 加重集約:注意重みで隣接ノードの特徴を集約し、自身の情報も保持

4. マルチヘッド強化:中間層で複数のヘッド出力を結合し次元拡張、出力層で平均を取り安定性向上

二、核心の長所(GCNとの比較)

- 自適応加重:グラフ構造に依存せず、データ駆動で重みを学習し、複雑な関係により適合

- 高効率並列:隣接重みは独立計算可能で、全体の隣接行列に依存せず、大規模・動的グラフに適応

- 解釈性:注意重みは可視化可能で、重要な接続や意思決定の根拠を分析しやすい

- 一般化能力:未

一、核心原理(一言+フロー)

- 一言:ノードは「どの隣接ノードにより注意を向けるか」を学習し、注意重みで隣接情報を加重集約して、より正確なノード表現を得る。

- 計算フロー:

1. 線形変換:ノード特徴を重み行列で投影し新空間へ

2. 注意計算:自己注意を用いて隣接ノード間の関連スコアを算出し、softmaxで正規化

3. 加重集約:注意重みで隣接ノードの特徴を集約し、自身の情報も保持

4. マルチヘッド強化:中間層で複数のヘッド出力を結合し次元拡張、出力層で平均を取り安定性向上

二、核心の長所(GCNとの比較)

- 自適応加重:グラフ構造に依存せず、データ駆動で重みを学習し、複雑な関係により適合

- 高効率並列:隣接重みは独立計算可能で、全体の隣接行列に依存せず、大規模・動的グラフに適応

- 解釈性:注意重みは可視化可能で、重要な接続や意思決定の根拠を分析しやすい

- 一般化能力:未

GAT-11.36%

- 報酬

- いいね

- コメント

- リポスト

- 共有

馬年ウサギは、混沌とした相場の中で誕生したミームの化身です。牛市や熊市を予測せず、大きな夢を描くこともありません。ただひたすら前進し続けることに専念します。馬年の突進のイメージとウサギ式の制御不能な精神を融合させ、このウサギは市場の感情が最も揺れるときに先頭に立ちます。ここには複雑なモデルはなく、速度、ミーム、コミュニティの共振、そして集団の遊び心だけがあります。あなたが買うのは未来ではなく、今の共通認識です;論理ではなく、笑いと信仰の積み重ねです。これは純粋なミーム駆動の実験であり、一緒に馬に乗り、一緒に狂奔したい人々に、ウサギがどこまで突き進めるかを見せるものです。

原文表示

[ユーザーは自分の取引データを共有しました。アプリに移動して詳細を表示します]

時価総額:$53.48K保有者数:49

100.00%

- 報酬

- いいね

- コメント

- リポスト

- 共有

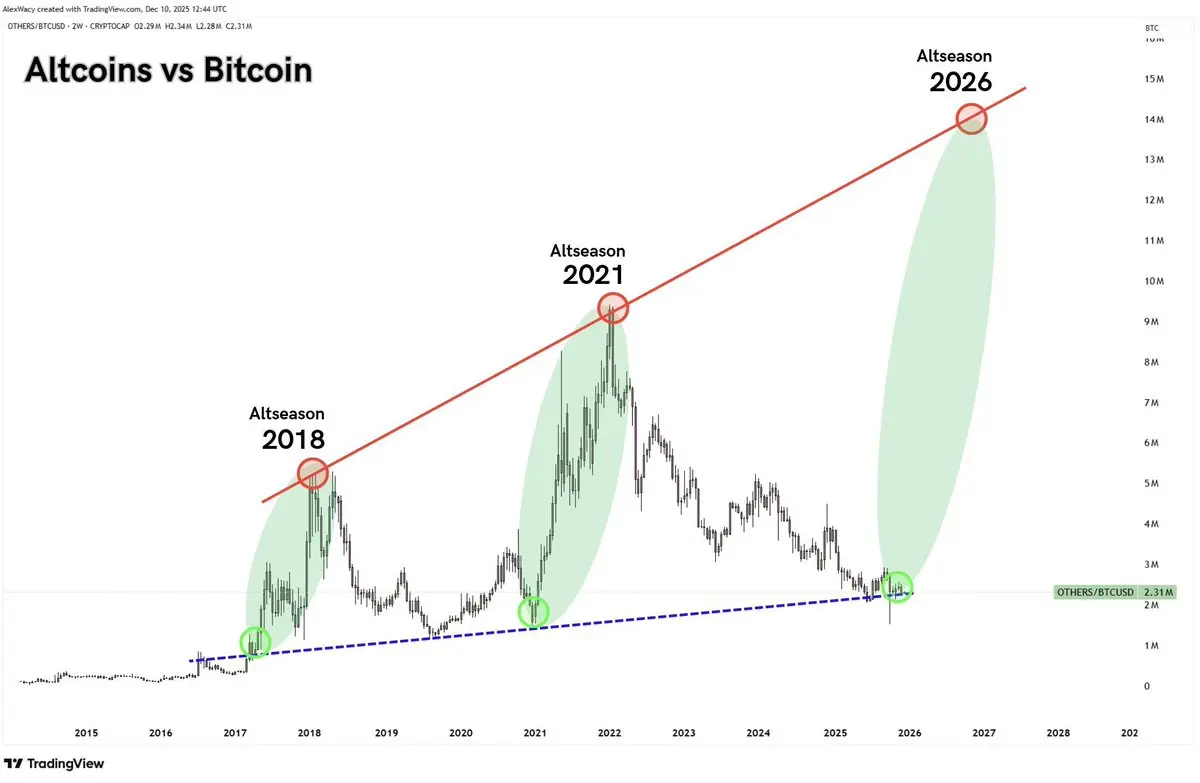

🚨 #ALTSEASON 2026がやってくる – そしてそれは巨大になる!

このチャートを見てください:アルトコインとビットコインの支配率は完璧な上昇トレンドをたどっています。2018年に成功し、2021年に爆発的に成長し、今は?2026年はこれまでで最大のパンプを迎えようとしています。

ビットコインからアルトコインへと数十億が流入しています – 正しいポジションを取ればあなたのポートフォリオは10倍になるかもしれません!このサイクルを見逃さないでください。今のうちにその宝石を積み上げて、FOMOが来る前に準備しましょう。

あなたのトップのアルトコインは何ですか?下に書き込んでください!

#Altseason #CryptoBullRun #Bitcoin #Altcoins #CryptoGems

このチャートを見てください:アルトコインとビットコインの支配率は完璧な上昇トレンドをたどっています。2018年に成功し、2021年に爆発的に成長し、今は?2026年はこれまでで最大のパンプを迎えようとしています。

ビットコインからアルトコインへと数十億が流入しています – 正しいポジションを取ればあなたのポートフォリオは10倍になるかもしれません!このサイクルを見逃さないでください。今のうちにその宝石を積み上げて、FOMOが来る前に準備しましょう。

あなたのトップのアルトコインは何ですか?下に書き込んでください!

#Altseason #CryptoBullRun #Bitcoin #Altcoins #CryptoGems

BTC-2.23%

- 報酬

- いいね

- コメント

- リポスト

- 共有

アカウントは1k未満であってはなりません 🙌🏽

こんにちは、フォローしています🩵

原文表示こんにちは、フォローしています🩵

- 報酬

- いいね

- コメント

- リポスト

- 共有

技術的には、ゼロ知識証明は以前は計算量が多く、生成と検証も遅いため、最大のボトルネックでした;エンジニアリング面では、使いやすく安全なオフチェーンストレージと認証メカニズムを構築し、不正利用を防ぐ監査チャネルも設計しなければならず、コードを書くことだけでなく、法務と何度も議論する必要があり、作業量は非常に大きいです。さらに重要なのはエコシステムの側面——規制当局、信託銀行、取引所、監査人が、「詳細を明かさずにコンプライアンスを証明できる」この方法を認める必要があり、そうでなければ技術が優れていても、空中楼閣に過ぎません。

しかし、これこそがDuskの価値の所在です:それは実験室で学術的な実験を行うことではなく、概念の投機に頼ることでもなく、これらの暗号学技術やエンジニアリングソリューションを一歩一歩、監査可能で実現可能なものに変えていくことです。Duskは「プライバシー」をスローガンや情熱の話題から、技術で解決できるエンジニアリングの問題に変えました:どの情報を隠すべきか、いつ公開すべきか、誰に公開するか、公開された情報が合法かつ真実であることをどう証明するか——これらすべてをプロトコルやスマートコントラクト、日常の運用フローに書き込むことができます。

@DuskFoundation $DUSK #Dusk

しかし、これこそがDuskの価値の所在です:それは実験室で学術的な実験を行うことではなく、概念の投機に頼ることでもなく、これらの暗号学技術やエンジニアリングソリューションを一歩一歩、監査可能で実現可能なものに変えていくことです。Duskは「プライバシー」をスローガンや情熱の話題から、技術で解決できるエンジニアリングの問題に変えました:どの情報を隠すべきか、いつ公開すべきか、誰に公開するか、公開された情報が合法かつ真実であることをどう証明するか——これらすべてをプロトコルやスマートコントラクト、日常の運用フローに書き込むことができます。

@DuskFoundation $DUSK #Dusk

DUSK-30.34%

- 報酬

- いいね

- コメント

- リポスト

- 共有

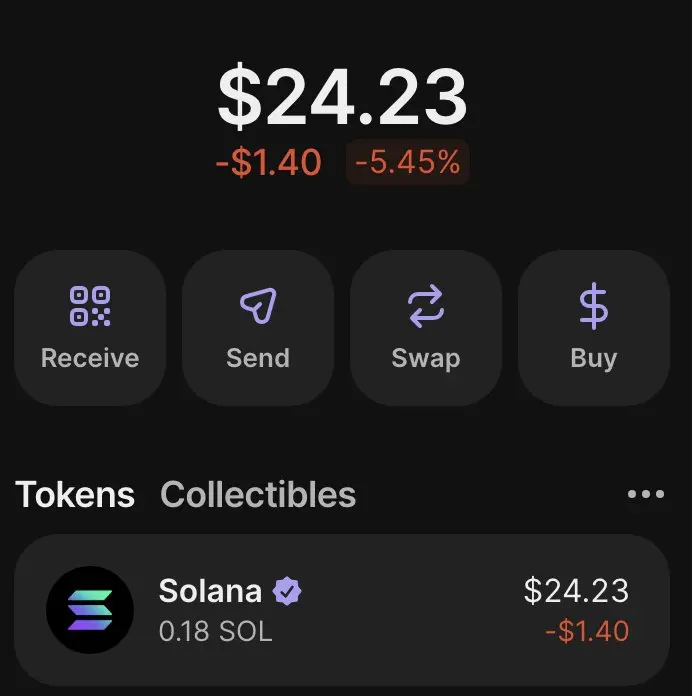

約束通り🥰に戻ってきました

$25 →$10,000チャレンジを再開する時が来ました

前回は約7日かかりましたが、今回はもっと早くやってみます

もし一緒に参加したい場合は、下にコメントしてくれれば、コールグループへの招待を送ります

コメントは24時間以内にロックします

原文表示$25 →$10,000チャレンジを再開する時が来ました

前回は約7日かかりましたが、今回はもっと早くやってみます

もし一緒に参加したい場合は、下にコメントしてくれれば、コールグループへの招待を送ります

コメントは24時間以内にロックします

- 報酬

- いいね

- コメント

- リポスト

- 共有

もっと詳しく

成長中のコミュニティに、40M人のユーザーと一緒に参加しましょう

⚡️ 暗号通貨ブームのディスカッションに、40M人のユーザーと一緒に参加しましょう

💬 お気に入りの人気クリエイターと交流しよう

👍 あなたの興味を見つけよう

人気の話題

もっと見る428 人気度

30.66K 人気度

47.86K 人気度

9.56K 人気度

7.6K 人気度

人気の Gate Fun

もっと見る- 時価総額:$3.43K保有者数:10.00%

- 時価総額:$3.43K保有者数:10.00%

- 時価総額:$3.48K保有者数:20.14%

- 時価総額:$3.8K保有者数:21.75%

- 時価総額:$3.51K保有者数:20.07%

ニュース

もっと見るピン